Mục lục bài viết

- Hiện tại Amazon SageMaker Training đã hỗ trợ Amazon EC2 P6-B200!

- Trước tiên chúng ta nói về SageMaker Training

- Amazon SageMaker Training có 3 cách tiếp cận:

- Các tính năng khác

- Các khuyến nghị khi bắt đầu training

- Kết luận:

Việc setup server, cài đặt GPU driver, quản lý tài nguyên tốn nhiều thời gian và công sức cho doanh nghiệp và cá nhân các nhà phát triển, cho nên Amazon SageMaker Training chính là công cụ tuyệt vời giúp bạn tập trung vào điều quan trọng nhất – xây dựng mô hình AI của mình.

Hiện tại Amazon SageMaker Training đã hỗ trợ Amazon EC2 P6-B200!

Các thông số kỹ thuật của P6-B200:

- Hiệu suất gấp đôi so với P5en instances

- 8 GPU Blackwell với 1440 GB bộ nhớ GPU tốc độ cao

- Băng thông tăng 60% so với thế hệ trước

- Mạng EFAv4 lên đến 3.2 terabit/giây

- AWS Nitro System đảm bảo mở rộng lên đến hàng chục nghìn GPU

Các thông số ấn tượng trên giúp cho việc training model trở nên thuận tiện và nhanh chóng hơn rất nhiều.

Trước tiên chúng ta nói về SageMaker Training

Thay vì phải build cơ sở hạ tầng, cài đặt các công cụ, thuê GPU, … đế training model. Thì trên AWS đã có sẵn công cụ tích hợp tất cả các điều này.

Cho nên với SageMaker Training, chúng ta chỉ cần tập trung vào code( tức là việc xây dựng business cho việc đào tạo mô hình) cũng như dữ liệu đầu vào.

Amazon SageMaker Training có 3 cách tiếp cận:

1. Dành cho người mới: No-code với SageMaker Canvas

Phù hợp khi:

- Bạn không biết code hoặc không muốn code

- Muốn thử nghiệm nhanh với AI

- Cần kết quả nhanh cho business

Cách dùng:

- Upload data

- Click chọn loại model

- Nhấn “Train”

- Đợi kết quả!

Ví dụ thực tế:

Một shop online muốn dự đoán doanh thu tháng sau dựa trên data bán hàng – chỉ cần upload file Excel và chọn “Forecast”!l

2. Level trung bình: Built-in Algorithms

Phù hợp khi:

- Biết Python cơ bản

- Muốn tùy chỉnh hyperparameters

- Cần algorithms chuyên biệt như XGBoost

Code ví dụ:

from sagemaker import XGBoost

# Khởi tạo model

xgb = XGBoost(

entry_point="train.py",

role=role,

instance_type="ml.m5.xlarge",

instance_count=1,

hyperparameters={

"max_depth": 5,

"eta": 0.2,

"objective": "binary:logistic"

}

)

# Train model

xgb.fit({"train": train_data})Use case:

Ngân hàng dự đoán khả năng vỡ nợ của khách hàng với XGBoost.

3. Pro level: Custom Scripts & Containers

Phù hợp khi:

- Cần kiểm soát hoàn toàn

- Train model phức tạp, scale lớn

- Sử dụng frameworks đặc biệt

Sức mạnh:

- Distributed training trên hàng trăm GPU

- Custom Docker containers

- Tích hợp với mọi ML framework

Ví dụ:

Startup AI Việt Nam train model nhận diện giọng nói tiếng Việt với custom architecture trên 100 GPU instances.

Các tính năng khác

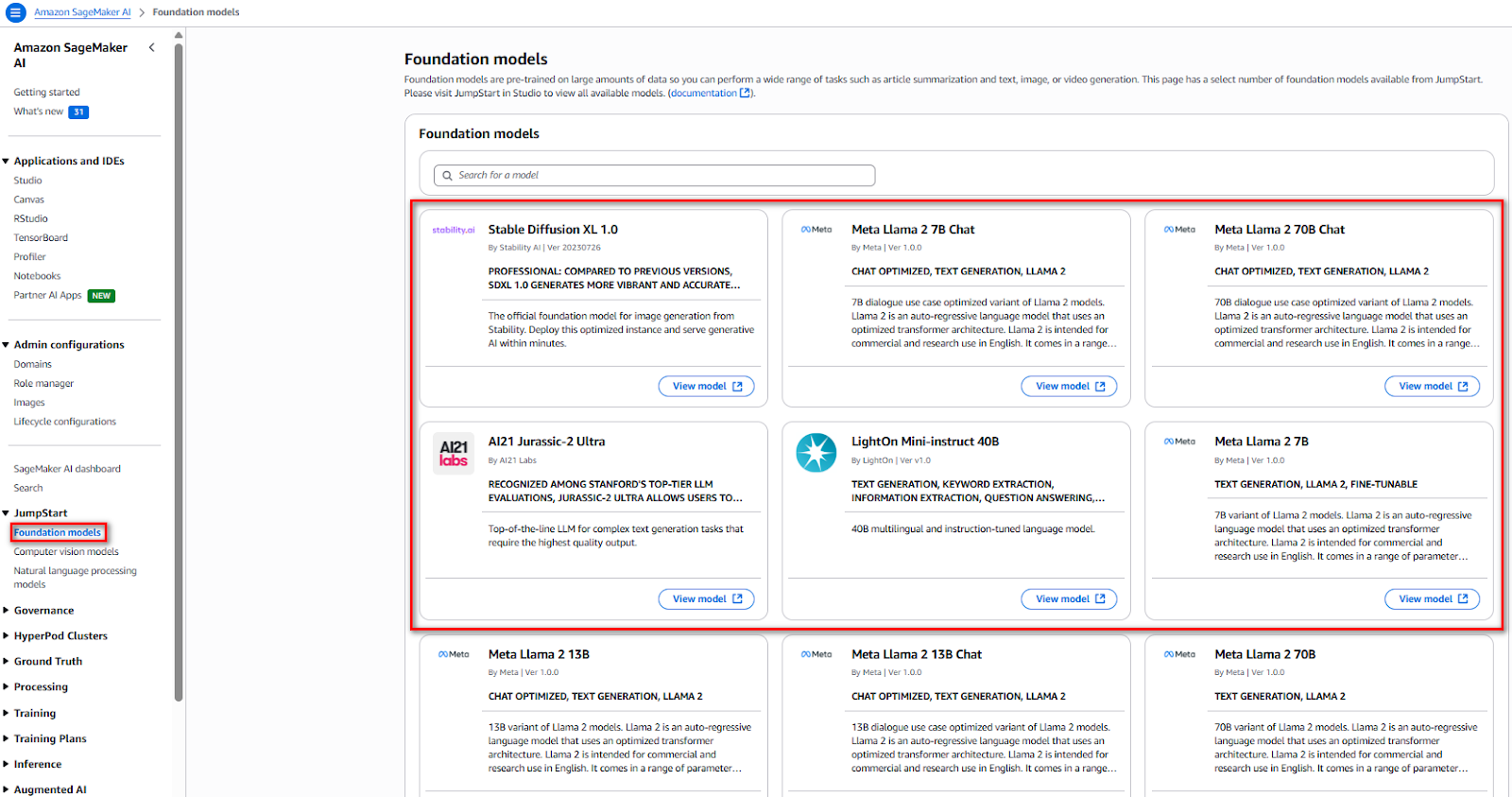

1. SageMaker JumpStart – Đây gọi là kho các model

- Truy cập hàng trăm foundation models

- Fine-tune GPT, Claude, Llama… cho use case riêng

- Deploy trong vài click

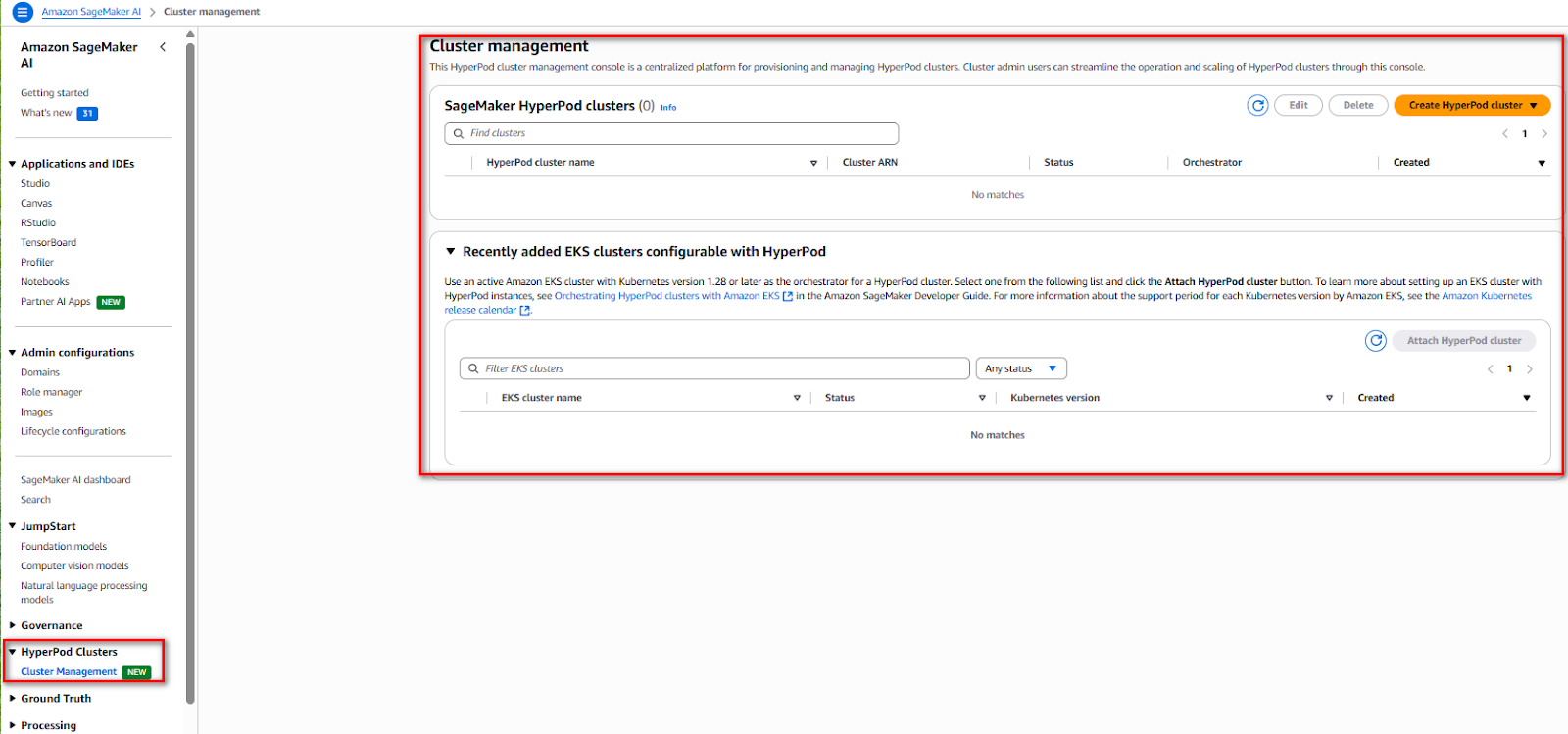

2. SageMaker HyperPod – Các Cluster GPU

- Cluster GPU persistent cho project lớn

- Tự động phục hồi khi có lỗi

- Scale lên hàng nghìn GPU

3. Hyperparameter Tuning – Chứa các hyperparameters

- Tự động thử nhiều combinations

- Tìm ra hyperparameters tốt nhất

- Tiết kiệm hàng tuần tuning thủ công

4. Distributed Training – Phân chia nhỏ để training

- Train model lớn trên nhiều GPU/instances

- Optimized cho AWS infrastructure

- Hỗ trợ PyTorch, TensorFlow, MXNet

Các khuyến nghị khi bắt đầu training

1. Bắt đầu nhỏ, scale sau

- Test với sample data trước

- Dùng instance nhỏ cho development

- Scale up khi production

2. Monitor everything

- Dùng SageMaker Debugger

- Track metrics với CloudWatch

- Profile performance bottlenecks

3. Version control

- Lưu model artifacts trong S3

- Track experiments với SageMaker Experiments

Kết luận:

Với Amazon SageMaker Training việc huấn luyện AI đã trở nên đơn giản hơn rất nhiều.

Chúng ta không cần chuẩn bị từ đầu giúp tiết kiệm thời gian hơn rất nhiều.

Hy vọng bài viết có ích và cảm ơn độc giả đã đọc đến cuối!

Để lại một bình luận